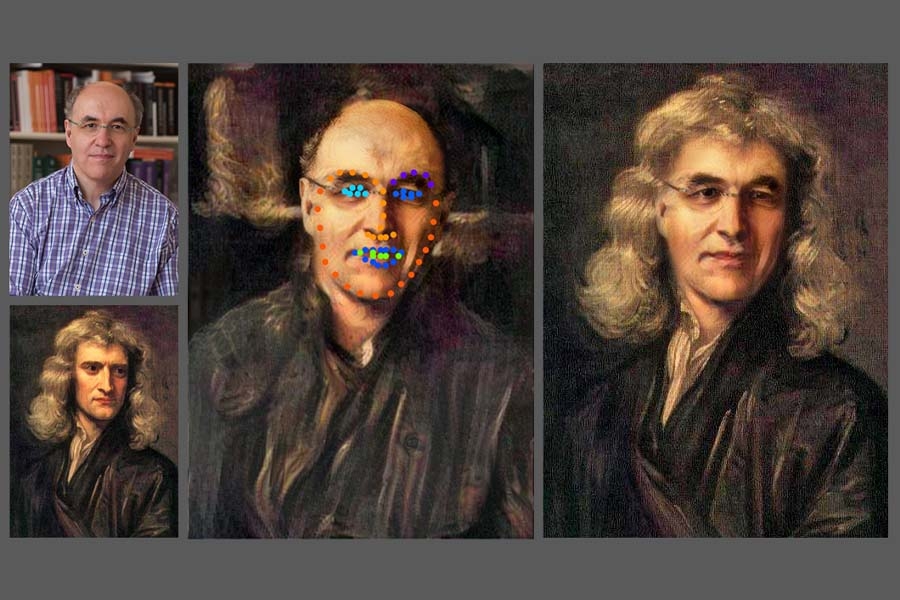

Foto: Stephen Wolframhttps:/creativecommons.org/licenses/by/2.0/deed.da

Mimikrija- Sa ovim alatom, svako ispred kamere može da liči na koga želi. „Dipfejk“ jednostavno skenira vaše lice i upoređuje karakteristike sa osobom čije lice želite da se pojavi umesto vašeg.

Ovaj alat nije ni nov ni nepoznat. Takve manipulacije se prvi put pojavljuju na fotografijama, još u 19. veku. Sa razvojem tehnologije, njihova zloupotreba se proteže i na video zapise.

Iako se smatra korisnim u filmskoj industriji, „dipfejk“ u medijima i društvenim mrežama već godinama predstavlja ozbiljan problem u borbi protiv lažnih vesti. Suština dipfejka do sada je bila podeljena na dva ključna faktora: duboko(dip) proučavanje i lažne (fejk) informacije.

Ova tehnologija je dovoljno složena za one medije što bez provere objavljuju sadržine koje smatraju činjenicama , a ustvari su lažne.

Zloupotreba je najviše prisutna u politici

Najveća upotreba „dipfejka“-a je da se izjave političara izvlače iz konteksta. Mediji širom sveta vrlo često znaju da nasednu na ovakve lažne snimke ili fotografije, koje prvo postanu viralne na društvenim mrežama poput „Tvitera” i „TikToka”.

I same društvene mreže godinama se muče da se izbore sa ovim fenomenom.

Rat u Ukrajini je na jedan način dodatno povećao širenje ovakvih dezinformacija. Kreatori ovih snimaka često znaju da manipulišu raznim izjavama ruskih ili ukrajinskih zvaničnika.

Jedan takav snimak ukrajinskog predsednika Volodimira Zelenskog, gde on navodno poručuje ukrajinskim vojnicima da se predaju, brzo se proširio društvenim mrežama, a pojedini mediji su „pali“ na ovaj potez i objavili snimak kao istinit.

Izborne kampanje su i događaji u kojima ovaj fenomen zna da dominira. Dezinformacije na američkim izborima 2018. bile su uglavnom među glavnim temama u američkim medijima posle izbora.

Imitacija glasa

Pitanje koje možda najviše zanima one koji nisu upoznati sa slučajem je kako se glas prenosi u ovim video snimcima i kako ostaje neprimećen u „dipfejk“ sadržaju.

Kreatori ovih snimaka su toliko vešti i umešni da tako tačno i precizno montiraju glas da zvuči baš kao osoba koja je cilj zloupotrebe. Tehnologija je dostigla takav nivo što program može za samo nekoliko sekundi da izimitira bilo šiji glas. Microsoft (Majkrosoft) takođe ima takav alat.

Oponašanjem glasa, takav sadržaj deluje još stvarnije, što ljudima olakšava da poveruju u njega.

Poznate ličnosti na porno sajtovima

Poznate ličnosti su takođe česta meta „dipfejka“. Video snimci poznatih ličnosti (glumci, muzičari, sportisti) često se pojavljuju na veb stranicama prepunim pornografskog sadržaja.

Tako su se, na primer, nedavno na društvenoj mreži „TikTok“ pojavili eksplicitni snimci poznate američke pevačice Bili Ajliš, koji su potom izbrisani.

U Velikoj Britaniji su se pojavile i informacije da su mnoge mlade devojke bile žrtve „dipfejka-a“, odnosno da su se njihova lica koristila na veoma eksplicitnim snimcima od strane školskih drugova sa ciljem da im naštete ili da ih uvenjuju.

Kako se države nose sa ovim?

Mnoge zemlje širom sveta godinama se bore protiv „dipfejk“ sadržaja.

Na primer, Engleska i Vels su zabranili pornografski „dipfejk“ sadržaj, a tamošnje vlasti će visoko kažnjavati takav nezakonit sadržaj velikim novčanim sumama.

Kina je u prethodnom periodu takođe odlučila da ozbiljnije poradi na ovom problemu. Peking je nedavno objavio prve “anti-dipfejk” zakone. Njihov cilj je da spreče zloupotrebu ove tehnologije dok se zemlja prilagođava brzom razvoju industrije veštačke inteligencije.

Od sada, baš kao i reklame u Kini, ljudi će moći da vide malu oznaku na dnu ovih video snimaka i slika, dajući gledaocima do znanja da to nije pravi sadržaj.

Evropska unija je 2020. godine objavila „Belu knjigu o veštačkoj inteligenciji“, predlažući niz mera za istraživanje i razvoj veštačke inteligencije i njen nadzor.

Ono što najviše zabrinjava u svemu ovome je činjenica da će se „dipfejk“ tek širiti i graditi. Sa napretkom tehnologije i veštačke inteligencije, kreatori ovog sadržaja imaće mnogo moćnija sredstva i alate za kreiranju tog sadržaja.

Borba protiv širenja lažnih vesti ostaje jedan od najvećih problema modernih demokratija, čije rešenje još uvek nije pronađeno.

Kako ojačati lokalne medije i obnoviti informisanje o radu opštinskih vlasti: Britansko rešenje daje rezultate

Kako ojačati lokalne medije i obnoviti informisanje o radu opštinskih vlasti: Britansko rešenje daje rezultate Saragusti: Niko sada nije bezbedan. Zločini su jezivi. Novinari su ubijeni dok obavljaju svoj posao

Saragusti: Niko sada nije bezbedan. Zločini su jezivi. Novinari su ubijeni dok obavljaju svoj posao Snaga dobre priče: O mitologiji medija

Snaga dobre priče: O mitologiji medija

Ostavljanje komentara je privremeno obustavljeno iz tehničkih razloga. Hvala na razumevanju.